An important factor for safer autonomous travel is minimising the risks that can lead to accidents. One major risk is the loss of satellite-based positioning signals (GNSS signal). Especially indoors and when flying out of sight and in rough terrain, a loss of connection can be fatal. In the best case, a homecoming function is activated, but an uncontrolled crash is also a likely scenario. So the goal is to ensure that the flight can continue smoothly even in this case. Something we work on every day at Spleenlab. An interplay of machine learning, AI and sensor data is essential here.

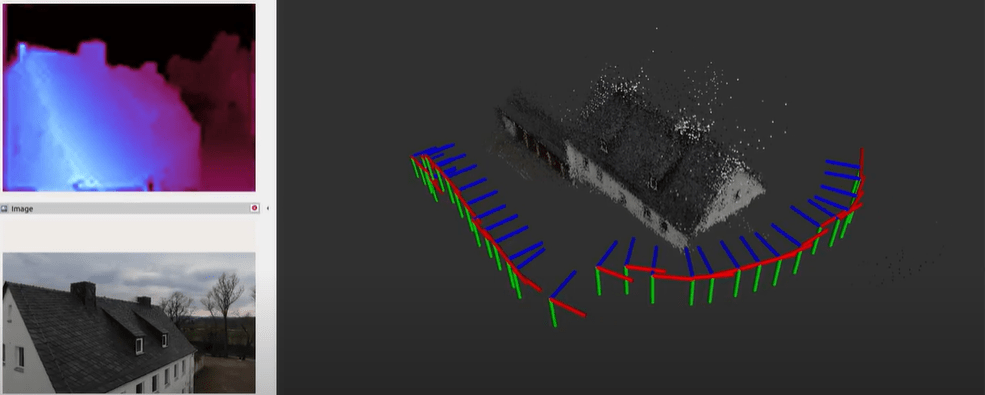

The goal is to calculate one’s own position in real time and to build a 3D model of the environment. This can happen from the interaction of various sensor data or, thanks to so-called visual odometry, be generated directly from camera images. This approach is revolutionary as far as the use of sensor technology is concerned, since all automated air and ground vehicles have corresponding cameras. The use of a lidar laser can be dispensed with.

Crucially, Visual Odometry in real time and embedded in the respective system (e.g. via an Nvidia Jetson or Xavier AGX board or integrated in the Auterion Skynode and AI Node) enables these functions on the vehicle without the need for a controller or ground station to intervene. In its compactness and complexity, this concept is easily adaptable to a wide range of domains (vehicles of all kinds, UAV, or for fast and high-flying manned aviation, e.g. helicopter or air taxi) and operational scenarios. Regardless of whether indoor or outdoor.

German Version:

Wie werden Flüge außerhalb der Sicht und Indoor noch sicherer auch ohne GNSS Signal?

Ein wichtiger Faktor für die sicherere autonome Fortbewegung ist das Minimieren von Risiken, die zu Unfällen führen können. Ein großes Risiko ist der Verlust von satellitengestützten Positionssignalen (GNSS Signal). Gerade in Innenräumen und bei Flügen außerhalb der Sicht und in unwegsamen Gelände, kann ein Abriss der Verbindung fatal sein. Im besten Fall wird eine Homecoming Funktion aktiviert, jedoch ist auch ein unkontrollierter Absturz ein wahrscheinliches Szenario. Ziel ist es also, auch in diesem Falle dafür zu sorgen, dass der Flug reibungslos fortgesetzt werden kann. Etwas woran wir bei Spleenlab tagtäglich arbeiten. Dabei ist ein Zusammenspiel aus maschinellem Lernen, KI und Sensordaten essentiell.

Ziel ist es, die eigene Position in Echtzeit zu berechnen und ein 3D-Modell der Umgebung aufzubauen. Dies kann zum einem aus dem Zusammenspiel von verschiedenen Sensordaten passieren oder dank einer sogenannten Visual Odometry direkt aus Kamerabildern erzeugt werden. Dieser Ansatz ist, was den Einsatz von Sensorik angeht, revolutionär, da alle automatisierten Luft- und Bodenfahrzeuge über entsprechende Kameras verfügen. Auf den Einsatz eines Lidar-Lasers kann dabei verzichtet werden.

Entscheidend ist, dass die Visual Odometry in Echtzeit und eingebettet in das jeweilige System (z.B. über ein Nvidia Jetson oder Xavier AGX Board oder integriert in die Auterion Skynode und AI Node) diese Funktionen auf dem Vehikel ermöglicht, ohne dass ein Steuerer oder eine Bodenstation eingreifen muss. Dieses Konzept ist in seiner Kompaktheit und Komplexität problemlos auf unterschiedlichste Domänen (Fahrzeuge aller Art, UAV, oder für schnell und hoch fliegende bemannte Luftfahrt, z.B. Helikopter oder Air Taxi) und Einsatzszenarien anpassbar. Egal ob Indoor oder Outdoor.