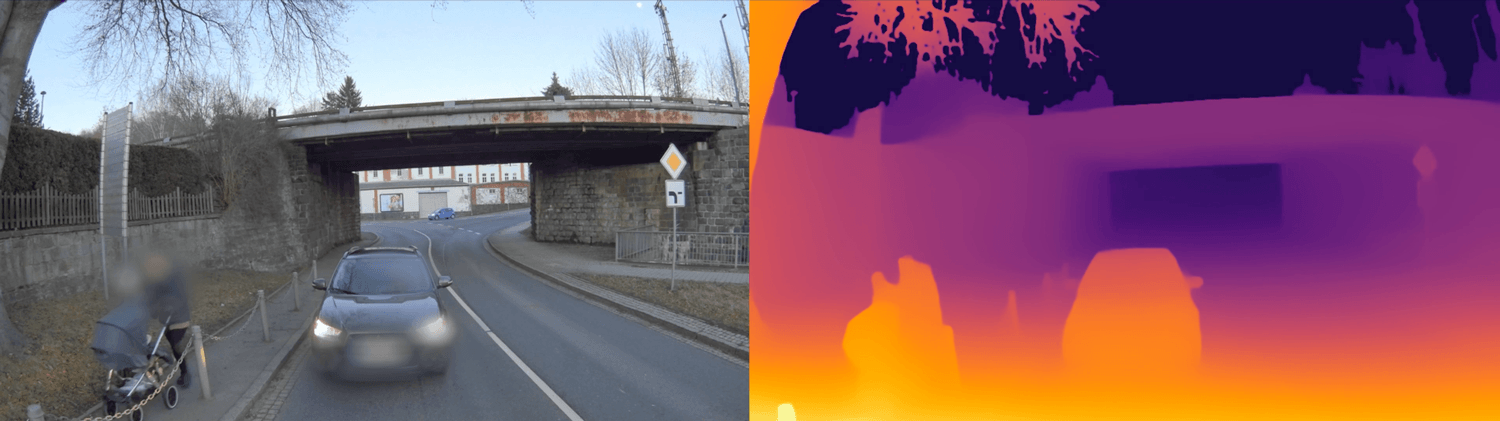

How can fully automated locomotion be enabled in a cost-effective and safe manner while minimizing the use for sensor technology and the effort for data labeling? A new and groundbreaking approach is monocular depth estimation, which in combination with a deep learning approach can enable exactly this. Depth estimation of an image or data set, i.e., measuring the distance of the vehicle to objects, is essential for reliable environment perception. Until now, this has relied on the use of multiple cameras (stereo) or redundant sensor technology (camera, lidar, etc.). In addition, there is the complex labeling of data in order to make the AI or the vehicle „familiar“ with its environment.

With the monocular depth estimation in connection with a „self-supervised“ Deep Learning principle it is possible to recognize its environment with only one (cheap) camera and to get depth information. The results are similar to a pseudo lidar. Additionally, the generated point clouds are denser than those of lidars. This promises not only high accuracy but also maximum safety. With simultaneous cost savings (by omitting a lidar laser). Thus, large video data can be generated quickly and easily. These are sufficient to recognize the environment with simple video data and to estimate the distance with the help of Deep Learning methods. . Manual data annotations or the use of reference sensor technology, as mentioned above, become unnecessary.

Thus, highly scalable and inexpensive data acquisition is possible, eclipsing previous methods and applications. Crucially, this approach is both real-time capable and applicable to different camera types, such as fisheye cameras. Furthermore, multitask training can be used to train better semantic segmentation. This „simplification“ is a revolutionary „game changer“ not only in autonomous driving, but in all types of autonomous mobility. Let’s enjoy talking together about the different application possibilities. We look forward to hearing from you.

Learn more now: www.spleenlab.com/monodepth_objectdetection

German Version:

Monokulare Tiefenschätzung – Weniger Sensorik, weniger manuelle Datenannotation, gleiche Sicherheit, höchste Effizienz

Wie lässt sich vollautomatisierte Fortbewegung kosteneffizient und sicher ermöglichen und gleichzeitig der Einsatz für Sensorik und der Aufwand für Datenlabeling minimieren? Ein neuer und bahnbrechender Ansatz ist die monokulare Tiefenschätzung, die in Verbindung mit einem Deep Learning Ansatz genau dies ermöglichen kann. Für eine sichere Umfeldwahrnehmung ist die Tiefenschätzung eines Bildes oder Datensatzes, also das Messen der Entfernung des Vehikels zu Objekten essentiell. Bisher wurde dabei auf den Einsatz von mehreren Kameras (Stereo) oder redundanter Sensorik (Kamera, Lidar etc.) gesetzt. Hinzu kommt das aufwendige labeln von Daten, um die KI bzw. das Vehikel mit seinem Umfeld „bekannt“ zu machen. Mit der monokularen Tiefenschätzung in Verbindung mit einem „self-supervised“ Deep Learning Prinzip ist es möglich, mit nur einer (günstigen) Kamera sein Umfeld zu erkennen und Tiefeninformationen zu erhalten.

Dabei sind die Resultate ähnlich einem Pseudo Lidar. Zusätzlich sind die erzeugten Punktwolken dichter als die von Lidaren. Dies verspricht nicht nur eine hohe Genauigkeit sondern auch ein Höchstmaß an Sicherheit (ASIL-B ready). Spleenlab bietet die erste KI für funktionale Sicherheit. Bei gleichzeitiger Kostenersparnis (durch verzicht auf einen Lidar Laser). So können schnell und einfache große Videodaten erzeugt werden. Diese reichen um mit o.g. Hilfe von Deep Learning Verfahren das Umfeld mit einfachen Videodaten zu erkennen und die Entfernung zu schätzen. . Manuelle Datenannotationen oder der Einsatz von Referenz-Sensorik, wie oben bereits erwähnt, werden dadurch überflüssig. So ist eine hochgradig skalierbare und günstige Datenbeschaffung möglich, die bisherige Verfahren und Anwendungen in den Schatten stellt.

Entscheidend dabei ist, dass dieser Ansatz sowohl echtzeitfähig, als auch für unterschiedliche Kameratypen, wie zum Beispiel bei Fisheye-Kameras eingesetzt werden kann. Durch das Multitask-Training kann darüber hinaus eine bessere semantische Segmentierung trainiert werden. Diese „Vereinfachung“ ist nicht nur im autonomen Fahren, sondern bei allen Arten der autonomen Mobilität ein revolutionärer „Game Changer“. Lassen Sie uns gerne gemeinsam über die unterschiedlichen Anwendungsmöglichkeiten sprechen. Wir freuen uns von Ihnen zu hören.

Jetzt mehr erfahren: www.spleenlab.com/monodepth_objectdetection